Сегодня компании соревнуются в умении чувствовать клиента. Эмоциональный ИИ превращает догадки в данные: он замечает улыбку, улавливает раздражение в голосе, читает настроение между строк. Машина становится инструментом, который помогает бизнесу понимать человека не по шаблону, а по живым реакциям.

По данным Markets and Markets, объем рынка эмоционального ИИ вырастет с 19 до 37 миллиарда долларов к 2026 году. такой рост говорит сам за себя. Эмоции становятся новой метрикой эффективности, и компании, которые научатся считывать их точно, получают преимущество, недоступное цифрам отчёта.

Пора разобраться, как это работает и почему это важно именно для вас.

Как система распознает эмоции

Эмоциональный ИИ — это технологии, которые учат машины распознавать чувства. Камеры и микрофоны считывают мимику, голос и взгляд, превращая эмоции в данные. Иногда подключаются датчики, фиксирующие пульс и дыхание, но чаще достаточно бесконтактного наблюдения, чтобы понять, радуется человек или сдерживает раздражение.

Что ИИ считывает эмоции

Эмоциональный ИИ считывает эмоции так, как это не удаётся обычным алгоритмам. Он превращает мимику, голос, движения тела и даже ритм сердца в измеримые данные. Система работает на трёх уровнях: визуальном, аудиальном и физиологическом, каждый открывает отдельную грань эмоционального состояния.

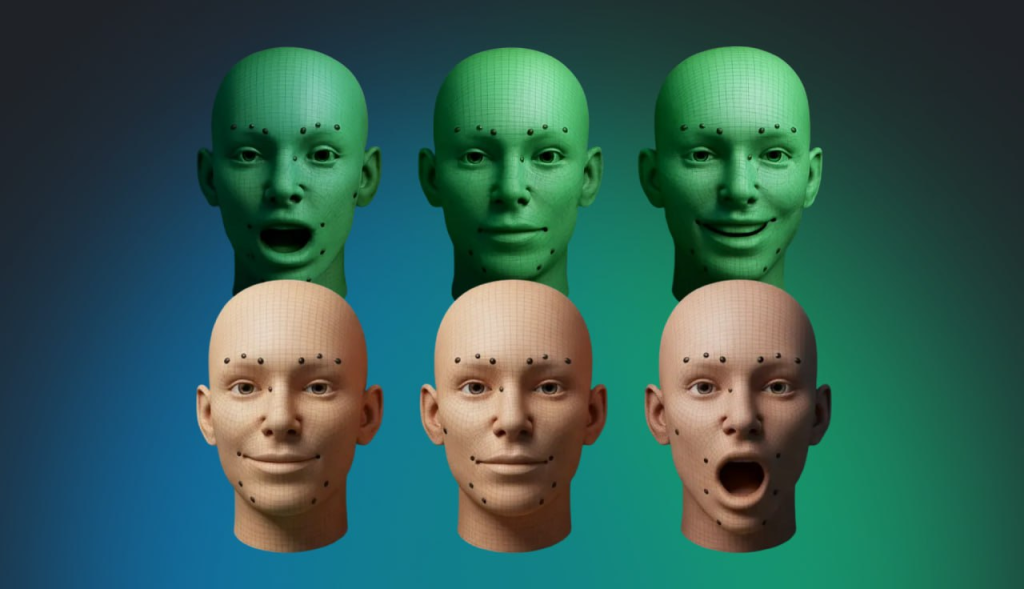

1. Визуальный анализ

Камеры фиксируют лицо и ищут ключевые точки — брови, глаза, уголки рта, носогубные складки, движение глаз и микровыражения, которые человек сам не замечает. Алгоритм сначала обрабатывает изображение, затем выявляет Action Unit’ы — мельчайшие микродвижения мышц. Нейросеть сравнивает эти точки с миллионами паттернов эмоций и видит мельчайшие микродвижения мышц: поднятые уголки губ, напряженные брови, морщинки на лбу. По этим сигналам система различает настоящую радость, усталость, или вежливую улыбку, оценивая интенсивность эмоции.

2.Голос и речь

Голос раскрывает вторую перспективу. Алгоритм анализирует тон, тембр, громкость, скорость речи, паузы и лексику. Стресс делает голос выше и быстрее, грусть — монотонным и слабым. Совмещение звучания и слов позволяет ИИ видеть настроение с высокой точностью.

3.Физиология

Для максимальной точности подключают сенсоры, которые считывают пульс, сердечные ритмы, мышечные импульсы и дыхание. Эти показатели отражают внутреннее напряжение и уровень возбуждения. Даже если лицо улыбается, тело выдает настоящие эмоции.

Как ИИ перерабатывает эмоции в цифру

1. Сбор данных

Первый шаг — наблюдение. Камеры фиксируют лицо, микрофоны записывают голос, сенсоры считывают пульс, дыхание и мышечные импульсы. Даже мельчайшие движения глаз или изменение тона голоса попадают в объектив.

2. Обработка и нормализация

Сырые данные слишком шумные и несовершенные. Камеры могут ловить тень, микрофон — фоновые шумы, датчики — помехи. Алгоритмы вычищают лишнее, приводят показатели к единому стандарту и выделяют ключевые признаки: поднятие бровей, ускорение речи, учащенный пульс. Всё это превращается в числовые векторы — база, на которой строятся дальнейшие выводы.

3. Сопоставление с паттернами

Теперь начинается работа нейросети. Система сравнивает каждый сигнал с миллионами примеров из базы данных: радость, удивление, грусть, раздражение. Алгоритм смотрит на сочетания микродвижений, тон голоса и физиологию, чтобы определить, какая эмоция скрыта за поведением человека. Каждому признаку присваивается оценка, и на выходе мы получаем первую цифровую карту эмоций.

4. Оценка интенсивности

Эмоции бывают разной силы. ИИ определяет, насколько радость настоящая или вежливая, стресс поверхностный или сильный, удивление лёгкое или шоковое. Микродвижения мышц, ритм речи и физиологические показатели объединяются в числа, которые отражают интенсивность каждой эмоции. Это позволяет видеть оттенки, которые человек сам может не осознавать.

5. Комбинация сигналов

Последний этап — слияние всех каналов в единую карту. Визуальные признаки, голосовые паттерны и физиология соединяются, чтобы показать полную картину эмоций. Это как собрать пазл из сотен кусочков: только когда они соединены, видна настоящая реакция человека. На выходе бизнес получает не просто оценку «радость/грусть», а цифры, которые отражают сложную эмоциональную динамику.

Где компании уже зарабатывают на эмоциональном ИИ

Эмоциональный ИИ перестал быть футуристической игрушкой и стал реальным инструментом бизнеса. Он измеряет эмоции, которые раньше оставались за кадром, и показывает, что люди на самом деле думают и чувствуют.

Розница и маркетинг

Самое очевидное применение — магазины и рекламные экраны. Cloverleaf и Affectiva создали электронные ценники shelfPoint с камерами. Проходящий покупатель автоматически попадает в поле зрения ИИ: система считывает выражение лица и меняет рекламу под реакцию. P&G, Walmart и другие тестировали технологию: продажи выросли на 10–40%, вовлеченность покупателей — в 3–5 раз. Система понимает, что вам нравится, и показывает это на экране, замечает разочарование — предлагает альтернативу.

Российский Promobot пошел дальше. Их роботы-консультанты с эмоциональным ИИ не просто отвечают на вопросы, они смотрят на лицо, слушают голос, считывают пульс и подстраивают тон. Видят стресс — становятся спокойнее, видят скуку — добавляют энергии. Люди доверяют им больше, потому что они ощущаются как собеседники, а не машины. Promobot работает в 34 странах в роли гидов, консультантов и промоутеров.

Кино и развлечения

Disney в 2017 году сняла эксперимент: 3179 зрителей, 16 миллионов изображений, камеры и алгоритмы распознавания эмоций. Система училась видеть, когда зрители смеются, вздрагивают или расстраиваются, и уже через несколько минут могла предсказать реакцию аудитории на фильм.

YouTube тестирует видео через YouFirst: зрители разрешают веб-камере фиксировать эмоции, нейросеть отслеживает реакции и передает данные авторам: где смех, где скука, где отвлечение.

Игры тоже подстраиваются под эмоции. Психологический триллер Nevermind от Affectiva реагирует на стресс игрока: если вы напряжены — игра становится жестче, если успокоитесь — расслабляет. Игра буквально «чувствует» вас.

Образование и HR

В Перми «Ростелеком» и New Vision создали «Умную и безопасную школу». Камеры анализируют эмоции учеников во время уроков, выявляют стресс или агрессию и позволяют вовремя вмешаться. Система работает с точностью 72%.

В HR эмоциональный ИИ тестирует кандидатов на собеседованиях. HireVue смотрит на выражение лица, слушает интонацию, анализирует движения, оценивает уверенность и честность. Результат — объективная оценка без предубеждений интервьюера.

Что нужно знать перед внедрением эмоционального ИИ

Эмоциональный ИИ впечатляет, но до телепатии ему далеко. Он видит эмоции, но не всегда понимает, что за ними стоит. Система фиксирует улыбку, но не знает, откуда она — радость, вежливость, сарказм или нервозность. Когда вы улыбаетесь продавцу, это не обязательно значит, что вам нравится товар. Без контекста ИИ теряет смысл, потому что человек живет не только в кадре, но и в собственном настроении.

Есть и технические нюансы. Чтобы ИИ работал точно, нужны:

-

качественная камера и хорошее освещение;

-

чистый аудиосигнал без фоновых шумов;

-

корректное расположение устройств;

-

отсутствие масок и очков, закрывающих лицо.

Как говорит Виталий Виноградов из Ivideon, при правильной настройке точность достигает 90–95%, но дешёвая техника сводит эту цифру к случайности.

Не все эмоции читаются одинаково. Культура, характер и даже привычка держать лицо влияют на результат. Одни люди реагируют открыто, другие — как актеры на допросе. Поэтому эмоциональный ИИ лучше работает с массовыми данными. Когда система анализирует тысячи людей, она видит не случайную улыбку, а тенденции, которые помогают бизнесу понять аудиторию.

Тренды в развитии эмоционального ИИ

К 2026 году больше половины онлайн-рекламы будут создавать с помощью эмоционального ИИ, прогнозирует Gartner. Рынок анализа эмоций удваивается каждые 2–3 года, а компьютерное зрение становится одной из главных технологий ближайших пяти лет.

Тренды:

-

Мультимодальные системы — одновременно смотрят на лицо, голос, тело и физиологию, видят эмоции точнее и не теряют контекст.

-

Обработка на периферии — смартфоны, очки и часы анализируют эмоции прямо на устройстве, быстрее и безопаснее.

-

Интеграция с IoT — умные дома, машины и города замечают усталость, скуку или стресс и реагируют.

-

Сложные эмоции — скука, замешательство, волнение, разочарование станут такими же измеримыми, как радость или злость.

Нажимая на кнопку, вы даете Согласие на обработку персональных данных в соответствии с Политикой.

Подписываясь, я даю свое Согласие на получение рассылок рекламного характера.